機(jī)器人在大規(guī)模高通量獲取作物表型信息的應(yīng)用上具有較大的潛力。自主導(dǎo)航技術(shù)是移動機(jī)器人研究中的一項(xiàng)重要內(nèi)容,但農(nóng)業(yè)場景的非結(jié)構(gòu)化特征給該項(xiàng)技術(shù)的研究帶來了巨大挑戰(zhàn),且在表型采集場景中機(jī)器人還面臨著場景變化大、高頻高重復(fù)性工作等具體問題。目前鮮有針對表型檢測機(jī)器人導(dǎo)航方法的研究。

華中農(nóng)業(yè)大學(xué)作物表型團(tuán)隊(duì)在Journal of Field Robotics在上發(fā)表了 題為''Autonomous navigation method based on RGB-D camera for a crop phenotyping robot''的論文。

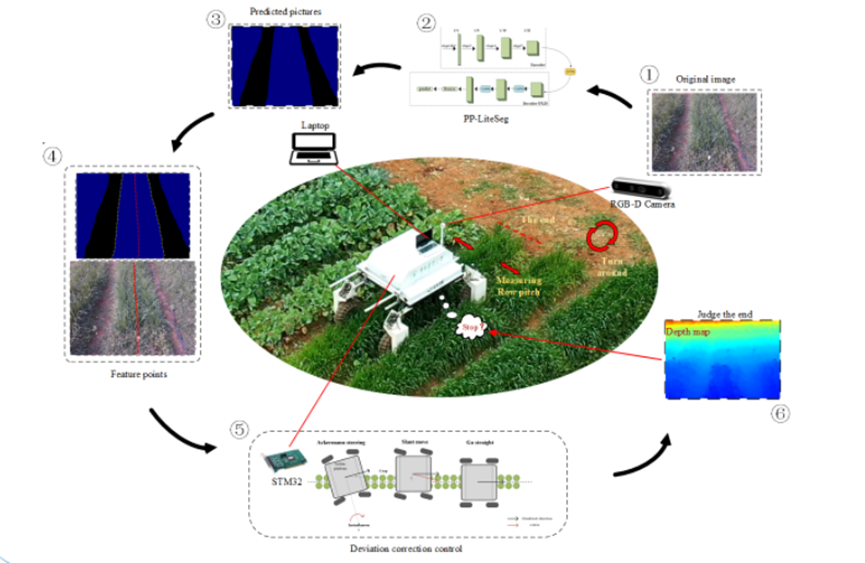

該研究提出了一種基于RGB-D相機(jī)的作物表型機(jī)器人自主導(dǎo)航方法,該方法建立了田間和盆栽兩種場景下多種作物圖像的導(dǎo)航數(shù)據(jù)集,采用實(shí)時(shí)性與準(zhǔn)確性均衡的語義分割模型對作物區(qū)域進(jìn)行分割,結(jié)合該區(qū)域深度信息,在真實(shí)世界坐標(biāo)系下提取導(dǎo)航線并獲得導(dǎo)航參數(shù),再根據(jù)兩個(gè)單輸入輸出模糊控制器對機(jī)器人實(shí)施糾偏控制。除此之外,該方法根據(jù)識別區(qū)域內(nèi)作物的平均高度和區(qū)域內(nèi)目標(biāo)的存在性判別機(jī)器人是否到達(dá)行末,最終根據(jù)行走時(shí)所測得的行距,控制機(jī)器人在末尾自動換行。

研究人員針對該方法進(jìn)行了大量可行性實(shí)驗(yàn)。實(shí)驗(yàn)結(jié)果表明,機(jī)器人的導(dǎo)航平均行走偏差為1.33cm,最大為3.82cm。此外,行間距測量的平均誤差為2.71cm,而掉頭換行的成功率為100%。該方法具有較高的準(zhǔn)確性及實(shí)用性,可以為表型機(jī)器人在戶外農(nóng)業(yè)環(huán)境的無人化作業(yè)提供有效支持。

文章鏈接:https://doi.org/10.1002/rob.22379

華中農(nóng)業(yè)大學(xué)作物表型團(tuán)隊(duì)黃成龍教授和團(tuán)隊(duì)博士生楊蒙為論文共同第一作者,宋鵬副教授為本文通訊作者。本研究得到了國家重點(diǎn)研發(fā)計(jì)劃項(xiàng)目(2022YFD2002304)、國家自然科學(xué)基金項(xiàng)目(U21A20205)、湖北省自然科學(xué)基金重點(diǎn)項(xiàng)目(2021CFA059)等項(xiàng)目的資助。